Après avoir décrit le principe de l’AR Cloud dans l’article précédent, je vous propose d’aller un peu plus loin dans le fonctionnement de ce concept. Nous allons nous efforcer de bien différencier les différentes parties de l’AR Cloud car elles ne sont pas toujours présentes suivant les définitions !

Le système universel de positionnement

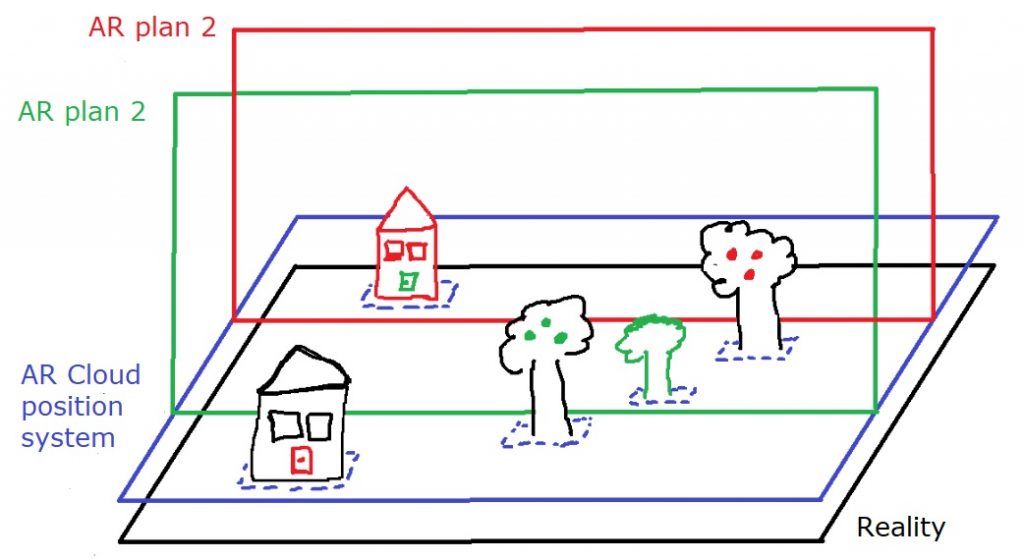

La première composante est le système de calage universel des choses, réelles ou numériques. C’est une sorte de super GPS qui doit fonctionner pour toutes les applications de RA utilisant d’AR Cloud. Sur le dessin ci-dessous vous pouvez avoir une idée du principe.

Chaque “plan RA” appartient à une application distincte qui possède ses propres « augmentations ». Le positionnement de ces objets par rapport au monde réel est partagé dans l’AR Cloud. Il est donc possible de localiser chaque élément DE chaque plan RA DANS chaque plan RA. Le positionnement et le rendu seront effectués in fine par l’application de l’utilisateur en utilisant les informations de l’AR Cloud.

Si on veut aller un peu plus dans le détail, il est possible de décomposer cette partie en deux composantes complémentaires. La première composante est la représentation numérique du réel (l’équivalent des marqueurs en RA) qui va servir de référence pour reconnaître le monde réel. La seconde composante va permettre de reconnaître et de “suivre” le réel (L’équivalent cette fois du SLAM en RA). Vous noterez qu’à ce niveau, nous ne parlons pas de « contenu » mais uniquement de son positionnement.

De nombreuses technologies peuvent être utilisées aujourd’hui pour alimenter la première composante, directement avec le GPS et ces alter-ego ou plus indirectement avec des marqueurs spécifiques. Nous avions fait dans un précédent article une liste assez complète pour le positionnement indoor. Cependant, le développement ces dernières années des outils de scan en volume embarqués dans Hololens, l’IphoneX ou les appareils Tango ajoutent une nouvelle perspective.

En effet, la facilité d’utilisation de ces scans (et leur caractère systématique) va produire une quantité énorme de données qui pourra être réutilisée dans l’AR Cloud. Ces cartographies 3D sont en réalité des nuages de millions de points 3D. Ils sont aujourd’hui très lourds et des entreprises travaillent à réduire leur taille afin de les placer le plus rapidement possible sur des serveurs, accessibles en temps réel pour la lecture. A l’extrême, avec un scan quasi permanent de l’environnement, on peut aller jusqu’à une modélisation / envoi / utilisation en temps réel de l’espace physique et ainsi disposer d’une marqueur ultime pour la RA. Je vous invite à jeter un oeil à cet article pour découvrir quelques initiatives sur la question de la relocalisation.

On rejoint ici l’idée d’une jumelle numérique de la Terre portée un moment par Google et par d’autres compagnies du numérique. Sans aller jusqu’à cette modélisation complète, on constate déjà aujourd’hui que ce concept de “Digital Twin” est très utilisé dans l’industrie et dans l’urbanisme (exemple de la ville de Namur). En constatant ses bénéfices, on peut postuler sans grand risque que cette duplication digitale va se développer dans les prochaine années.

Pour la seconde composante, il existe également des technologies matures de reconnaissance et de suivi d’images, de position, de modèles 3D, etc. Le challenge sera ici de travailler en temps réel sur des appareils hétérogènes. Je gage que la démocratisation de la 5G dans les années à venir va beaucoup aider !

Notez qu’il est finalement assez difficile de faire ici la différence entre une cartographie et un moteur de recherche pour cette partie de l’AR Cloud. Peut-être parce que cette partie combine les deux éléments et à pour vocation de donner à l’explorateur la carte ET la boussole de ces mondes numériques qui s’ouvrent devant eux. C’est d’ailleurs cette idée qui en fait fantasmer plus d’un … rappelons-le, Google est à l’origine un moteur de recherche 🙂

La gestion du contenu

Nous voilà ici dans la seconde grosse partie de l’AR Cloud, la gestion du contenu et des interactions qui lui sont associées. Les contours de cette partie ne sont pas encore vraiment clairs et les différents projets l’abordent différemment (ou pas du tout s’ils se limitent au positionnement dont nous venons de parler). Cette partie a pour objectif de répondre au problème de persistance des objets augmentés, d’interopérabilité entre outils et tente également de structurer les types d’interactions possibles pour s’affranchir de la variabilité des appareils.

“You will probably hear about the ARCloud a lot in coming months: If you’re confused, it’s not you, it’s them”

Matt Miesnieks – CEO @6D_ai

Nous pouvons envisager plusieurs scénarios pour le développement de cette partie, dont voici les deux pistes les plus extrêmes :

Evolution Verticale : Des bases de données géantes sont constituées par les gros acteurs du marché à partir des données disponibles comme Wikipédia, des producteurs de contenu (vous, moi) et des données générées par les utilisateurs. Cet ensemble de contenus, et très probablement de types d’interactions, forme un écosystème privé, potentiellement soumis à une licence d’utilisation.

On peut imaginer par exemple un trio Google/Microsoft/Tencent qui partage l’ensemble de ces contenus en rendant leurs interactions standardisées et utilisables dans un multitude de matériels (Lunette de RA, Casque de XR, TV, voiture, etc.). On crée une “planète numérique”, un AR Cloud, par écosystème.

S’il est difficile de voir vers quel scénario on va, probablement un mixte, on peut conjecturer cependant que la stabilisation du problème risque de prendre un peu de temps. Le couplage en particulier entre les méthodes d’interactions et les matériels disponibles reste un énorme challenge. Mais, comme le répète Matt Miesnieks ou Ori Inbar, c’est cette étape qui va permette de rendre la réalité augmentée « utile » dans un usage quotidien et donc ouvrir le vrai développement économique de la technologie.

Dans la 3ème et dernière partie de cette série d’articles, nous ferons un point sur les acteurs actuels de l’AR Cloud et nous poserons aussi quelques questions liées à son évolution.

Grégory MAUBON est consultant indépendant en réalité augmentée (animateur et conférencier) depuis 2008, où il a créé www.augmented-reality.fr et fondé en 2010 RA'pro (l'association francophone de promotion de la réalité augmentée). Il a aidé de nombreuses entreprises (dans plusieurs domaines) à définir précisément leurs besoins en réalité augmentée et les a accompagnées dans la mise en œuvre.