Nous avons abordé plusieurs fois sur site la question de l’utilité des lunettes « de RA ». Si, sur le plan professionnel, nous pouvons trouver de multiples exemples, dans le marché grand public, les choses sont très différentes. Au du moins, « étaient » très différentes jusqu’à aujourd’hui. Car, oui, il pourrait bien se passer un changement majeur avec l’arrivée de l’IA générative embarquée, peut etre que nous voyons se développer la killer app des « smart glasses ».

Un rapide tour historique

Pour reposer les choses, on trouve des lunettes connectées depuis assez longtemps. Mais c’est avec l’apparition des Google Glasses en 2014 qu’on commence à visualiser l’objet et ses usages potentiels. À partir de là et en résumant beaucoup, on voit deux tendances majeures. La première cible des marchés professionnels aux usages assez bien définie : expertise à distance, visualisation in situ, apprentissage devant une machine, etc. Les matériels sont autonomes, en fait des sortes d’ordinateurs à porter sur la tête. Dans cette catégorie on trouve les Hololens de Microsoft, les Magic Leap, les Moverio d’Epson, et avec des fonctionnalités plus limitées les gammes de Vuzix ou de Realwear. Les produits de cette catégorie ont montré leur utilité et son maintenant adoptés dans beaucoup de secteur.

La seconde tendance cible le marché des particuliers avec la volonté d’être un complément, voire un substitut, au smartphone. Ici, le développement a été bien plus chaotique et jusqu’en 2023, on peut dire qu’aucun succès n’a émergé. On peut rendre hommage à l’obstination d’entreprises comme Snap qui a lancé 3 générations de modèle « Spectacle » (2016, 2018, 2019), Facebook avec ses « Stories » créée en collaboration avec Rayban (2020) ou encore North, dont les « Focals » ont fait une brève apparition, avant d’être rachetée par Google puis liquidée. Il est presque impossible de faire la liste de toutes les tentatives, mais on peut au moins partager leur faiblesse commune : Ces lunettes ne proposent aucun usages à valeur ajoutée par rapport à un smartphone. Impossible donc de convaincre une masse d’utilisateurs, l’investissement est trop grand.

Les choses ont un peu évoluées « post-COVID » en 2021 avec l’arrivée d’une classe de lunettes ayant la fonction d’un écran déporté. Les Lenovo A3 sont caractéristiques de cette tendance, avec un écran de bonne qualité, un poids léger et une autonomie importante. Tous les autres éléments sont superflus, y compris les caméras pour certains modèles. Ces modèles ont eu un certain succès, en particulier auprès des travailleurs nomades, mais cela n’a pas été un raz de marée.

L’arrivée de l’IA générative, les « AI Glasses »

Les choses ont évolué le 27 septembre 2023 quand Mark Zuckerberg a présenté au cours de la Meta Connect 2023 le nouveau modèle de Ray-Ban Meta smart glasses. Nous l’avions souligné dans notre article récapitulatif, ces lunettes « intègrent les technologies d’IA de Meta avec la fonction centrale d’assister le porteur dans ses actions quotidiennes« . On passe donc de lunettes de RA à des lunettes d’IA, mais dans lesquelles la RA a toute sa place comme interface avec l’utilisateur. La fonction qui peut être cette fameuse Killer App ? L’assistance. Le statut des lunettes évolue en passant d’un simple écran à celui d’assistant personnel.

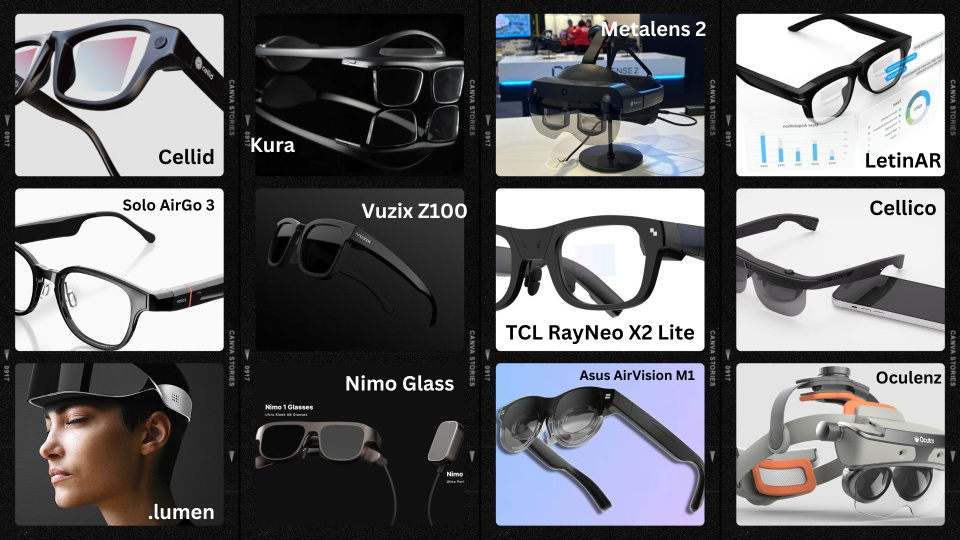

Depuis, de nombreux modèles ont été annoncés, au CES 2024 ou au Mobile World Congress. Les AirGo3 de Solos sont emblématiques de cette tendance puisque c’est devenu le principal axe de communication de la marque. Mais les autres constructeurs ne sont pas en reste. Les X2 Lite de RayNeo, les Nimo Glasses de Nimo Planet, les Air 2 Ultra de XREAL ou plus récemment les Brilliant Labs Frame convergent toutes vers le même modèle. Du côté des géants de la tech, on peut noter des développements similaires chez Amazon (avec l’intégration d’Alexa dans les Echos Frames), Google (plutôt en ciblant un OS « AI ready » en lien avec l’écosystème Qualcomm) et Microsoft (de manière encore très prudente).

Les caractéristiques communes

Avant de rentrer dans les détails techniques, constatons une chose assez simple : Pour être adoptées massivement, ces lunettes doivent avoir la forme de lunettes ! Cela peut paraitre stupide à préciser, mais cela impose de rudes contraintes : un poids de l’ordre de 100 grammes ou inférieur, une forme « fine », la possibilité de personnalisation des montures et des verres. Évidement, toutes les offres actuelles ne sont pas aussi complètes, mais toutes les marques tendent vers cela.

Si on s’intéresse maintenant à la technique, ces lunettes sont des dispositifs de réalité augmentée. Elles doivent donc avoir les 3 fonctionnalités des matériels de RA :

- Un dispositif de captation de l’environnement pour contextualiser le travail de l’IA. Aujourd’hui c’est souvent une caméra, mais on peut imaginer d’autres capteurs (micro, Lidar, etc.)

- Un dispositif de traitement de l’information, sous la forme probable d’une puce embarquée. Mais une partie de ce traitement peut être déporté sur le smartphone, ou plus loin, comme dans la proposition de Vodafone avec son HyperRealityHub.

- Un dispositif d’interaction avec l’utilisateur. Là encore, plusieurs choix sont possibles : des écrans, des hauts parleurs, etc.

Pour faire fonctionner tout cela, la question de l’énergie disponible est primordiale. Aujourd’hui, une paire de lunettes de RA fonctionne rarement sur une journée et il est peu probable qu’on puisse ajouter une batterie externe comme sur les casques de VR. Le rapport poids/puissance des batteries sera les enjeux des prochaines années. En attendant une solution parfaite, ces lunettes devront peut-être permettre le remplacement « à chaud ».

Cette question compliquée de gestion de l’énergie va probablement contraindre les dispositifs d’interaction avec l’utilisateur que nous avons évoqué plus haut, en tout cas dans les cinq prochaines années. Si Meta a fait le choix de ne pas mettre d’écran dans ses Ray-Ban Meta smart glasses c’est en partie à cause de la consommation énergétique.

Une conséquence prévisible de l’évolution vers les « AI glasses » sera la disparition des modèles n’ayant pas les 3 dispositifs évoqués plus haut. Les lunettes sans caméra, par exemple, peuvent déjà être mises au cimetière. Est-ce que les écrans déportés (comme les AirVision M1 de Asus) ou des dispositifs spécialisés (dans le sport par exemple) résisteront ? Je ne mettrai pas un gros pari là-dessus 🙂 Ils seront progressivement poussés hors du jeu, un peu comme les appareils photos par les smartphones.

Quels usages en pratique ?

Par définition, le premier usage de ces « AI glasses » sera l’assistance de l’utilisateur. L’appareil sera en mesure de fournir des informations contextualisées et personnalisées en s’appuyant, potentiellement, sur les applications du smartphone. On retrouve ici le concept du Rabbit R1. On peut déjà trouver des exemples comme les guides touristiques personnalisés proposés par Andrew Bosworth (CTO de Meta) ou les traductions en temps réel mises en avant par Solos et TCL. Les possibilités sont presque infinies, de la discussion à la formation, des soins aux divertissements.

L’avantage des lunettes est qu’elles sont déjà sur notre nez ! C’est un objet courant, qui ne fait pas peur, qui ne semble demander aucun apprentissage. Son acceptation est encore plus simple que celle du smartphone. Grâce à l’IA on devrait même pouvoir interagir naturellement, par la voix, ou plus classiquement par le téléphone.

D’ailleurs, est-ce que ces lunettes (ou dans un futur plus lointain les lentilles) peuvent remplacer le smartphone ? C’est assez probable puisqu’elles font devenir une « interface totale ». Les smartphones devraient être petit à petit relégués à leurs fonctionnalités (affichage, calcul, connectivité, etc.) puis, ces fonctionnalités étant intégrées, disparaitre. On a d’ailleurs vu avec l’exemple du HyperRealityHub qu’une partie de ces fonctionnalités pouvait être déportées.

Oui mais…

Tout a l’air parfait dans notre description précédente, mais, comme souvent dans le numérique, la réalité de l’utilisation pose un certain nombre de questions. Rapidement, voici quelques points de vigilance :

- Vie privée et surveillance : On comprend rapidement que, avec des caméras et des capteurs intégrés, ces lunettes pourraient enregistrer constamment ce que l’utilisateur voit et entend, posant des risques significatifs en termes de confidentialité et de surveillance non consentie.

- Sécurité des données : La collecte et le traitement des données par l’IA nécessitent des mesures de sécurité robustes pour protéger ces informations sensibles qui tracent une profil extrement intime de l’utilisateur. Dans le même ordre d’idée, la nationalité de l’entreprise qui constuit les lunettes (et donc le droit auquel elle est soumise, n’est pas à négliger.

- Problèmes éthiques dans le développement de l’IA : Les biais dans les algorithmes d’IA peuvent entraîner des discriminations et des préjugés dans la manière dont les informations sont présentées ou traitées par les lunettes de RA.

- Désinformation et manipulation : L’IA, qui comme on le sais n’est pas neutre, pourrait être utilisée pour créer ou diffuser des informations trompeuses, ou à minima orientées. Comment avoir confiance dans son assistant dans ce cas ?

- Dépendance à la technologie : L’accès facile et constant à l’IA pourrait augmenter la dépendance aux appareils technologiques, réduisant notre capacité à vivre sans assistance numérique. Il y a déjà beaucoup de débat sur les conséquences de l’utilisation de ChatGPT sur la créativité, je vous laisse imaginer les questionnement dans le cadre d’un assitant au quotidien !

- Distraction et sécurité : L’utilisation des lunettes de RA en conduisant ou dans d’autres situations nécessitant une attention complète pourrait augmenter le risque d’accidents.

- Dans le même ordre d’idée Surcharges sensorielles et cognitives : La quantité d’informations et d’interactions proposées par l’IA peut provoquer une « surcharge », rendant difficile la concentration sur le monde réel.

- Accessibilité et inégalité : Le coût des lunettes de RA avancées pourrait limiter l’accès aux technologies de pointe, creusant encore une fois le fossé numérique entre les différentes strates socio-économiques.

- Impact sur la santé : L’utilisation prolongée de lunettes de RA, particulièrement celles intégrant des écrans proches des yeux, pourrait avoir des effets négatifs sur la vision et la santé mentale.

- Obsolescence accélérée des appareils : L’évolution rapide de l’IA pourrait entraîner une obsolescence accélérée des lunettes de RA, contribuant à des problèmes environnementaux liés à la production et au recyclage des technologies.

Cette liste n’est évidement pas exhaustive mais permet au moins de commencer un questionnement de fond sur le sujet.

L’arrivée de l’IA comme application principale pour les lunettes AR pourrait changer en profondeur notre interaction quotidienne avec le numérique, n’ayons pas peur des mots, c’est peut être le début d’une nouvelle ère pour les technologies mobiles. Cette évolution ne va pas aller sans soulever une une série de problèmes potentiels.

Quelques Sources

- AR got its ‘killer app’: GenAI

- OPPO présente ses nouvelles lunettes de réalité augmentée OPPO Glass Air 3

- Lenovo Introduces the ThinkReality A3

- Meta Connect 2023 : oui Mark parle bien de réalité augmentée !

Grégory MAUBON est consultant indépendant en réalité augmentée (animateur et conférencier) depuis 2008, où il a créé www.augmented-reality.fr et fondé en 2010 RA'pro (l'association francophone de promotion de la réalité augmentée). Il a aidé de nombreuses entreprises (dans plusieurs domaines) à définir précisément leurs besoins en réalité augmentée et les a accompagnées dans la mise en œuvre.